ChatGPTを行政機関で用いる場合のリスクと懸念

スポンサーリンク

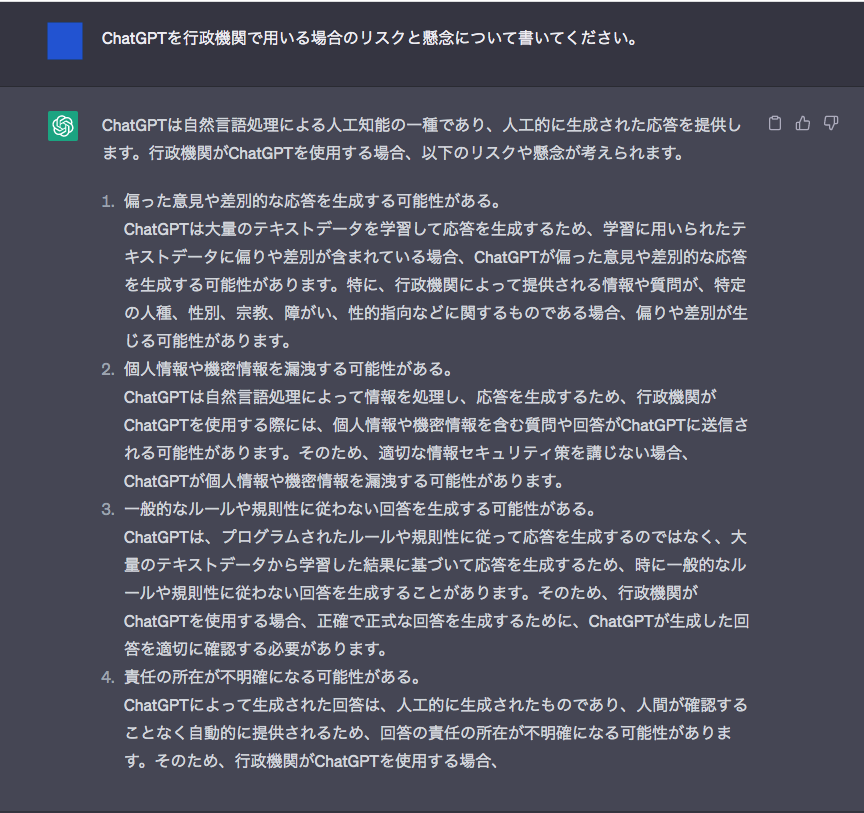

ChatGPTを行政機関で用いる場合のリスクと懸念について書きます。今回もChatGPTに直接、「ChatGPTを行政機関で用いる場合のリスクと懸念について書いてください。」と質問してみました。

ChatGPTは自然言語処理による人工知能の一種であり、人工的に生成された応答を提供します。行政機関がChatGPTを使用する場合、以下のリスクや懸念が考えられます。

1.偏った意見や差別的な応答を生成する可能性がある。

ChatGPTは大量のテキストデータを学習して応答を生成するため、学習に用いられたテキストデータに偏りや差別が含まれている場合、ChatGPTが偏った意見や差別的な応答を生成する可能性があります。特に、行政機関によって提供される情報や質問が、特定の人種、性別、宗教、障がい、性的指向などに関するものである場合、偏りや差別が生じる可能性があります。2.個人情報や機密情報を漏洩する可能性がある。

ChatGPTは自然言語処理によって情報を処理し、応答を生成するため、行政機関がChatGPTを使用する際には、個人情報や機密情報を含む質問や回答がChatGPTに送信される可能性があります。そのため、適切な情報セキュリティ策を講じない場合、ChatGPTが個人情報や機密情報を漏洩する可能性があります。3.一般的なルールや規則性に従わない回答を生成する可能性がある。

ChatGPTは、プログラムされたルールや規則性に従って応答を生成するのではなく、大量のテキストデータから学習した結果に基づいて応答を生成するため、時に一般的なルールや規則性に従わない回答を生成することがあります。そのため、行政機関がChatGPTを使用する場合、正確で正式な回答を生成するために、ChatGPTが生成した回答を適切に確認する必要があります。4.責任の所在が不明確になる可能性がある。

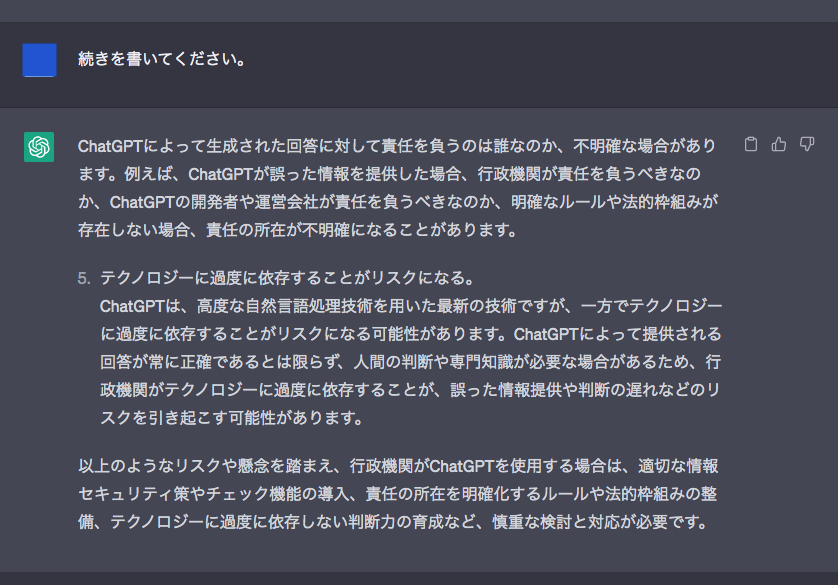

ChatGPTによって生成された回答は、人工的に生成されたものであり、人間が確認することなく自動的に提供されるため、回答の責任の所在が不明確になる可能性があります。そのため、行政機関がChatGPTを使用する場合、ChatGPTによって生成された回答に対して責任を負うのは誰なのか、不明確な場合があります。例えば、ChatGPTが誤った情報を提供した場合、行政機関が責任を負うべきなのか、ChatGPTの開発者や運営会社が責任を負うべきなのか、明確なルールや法的枠組みが存在しない場合、責任の所在が不明確になることがあります。5.テクノロジーに過度に依存することがリスクになる。

ChatGPTは、高度な自然言語処理技術を用いた最新の技術ですが、一方でテクノロジーに過度に依存することがリスクになる可能性があります。ChatGPTによって提供される回答が常に正確であるとは限らず、人間の判断や専門知識が必要な場合があるため、行政機関がテクノロジーに過度に依存することが、誤った情報提供や判断の遅れなどのリスクを引き起こす可能性があります。以上のようなリスクや懸念を踏まえ、行政機関がChatGPTを使用する場合は、適切な情報セキュリティ策やチェック機能の導入、責任の所在を明確化するルールや法的枠組みの整備、テクノロジーに過度に依存しない判断力の育成など、慎重な検討と対応が必要です。

質問後、得られた回答が上記となる。この回答を読んでみたが特に問題はなさそうだと判断し、情報として共有する。あと、この回答で気になったのが「責任の所在が不明確になる可能性がある」というものだ。行政機関ではないが、日本企業の責任の所在は、不明確な傾向があり、曖昧にしてしまう傾向がある。そこにChatGPTというものを用いた時にどのようなことが起きるのか、これからが気になるところだ。