従業員がChatGPTを使用する場合、雇用主のリスクや懸念について書きます。また、この記事は海外の記事を参照し気になるところをまとめたものである。

news.bloomberglaw.com

■「従業員がChatGPTを使用する場合、雇用主はこれらのリスクを考慮する必要があります(Employers Should Consider These Risks When Employees Use ChatGPT)」

・プライバシーと機密保持

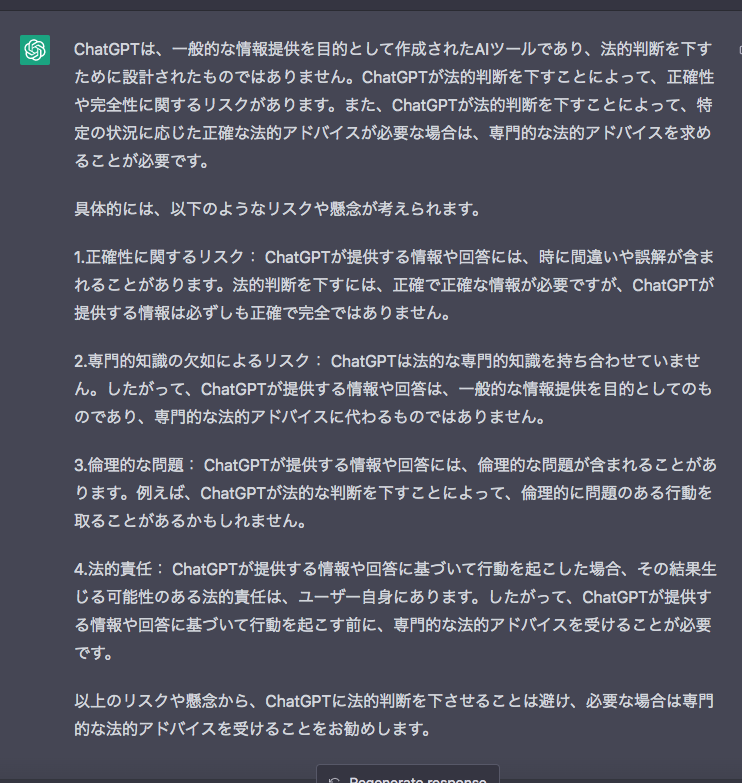

上記の記事も書かれているが「ChatGPT はオンライン上の様々な情報でトレーニングされているため、従業員はツールから商標、著作権、または他の個人や団体の知的財産の情報を受け取って使用する可能性があり、雇用主に法的リスクが生じる恐れがあるので注意する。

また法的問題に加えて、雇用主は、従業員が仕事に関連してChatGPTを使用できるようにする範囲を検討する必要がある。

www.debevoise.com

■「あなたの会社にはChatGPTポリシーが必要ですか?おそらく(Does Your Company Need a ChatGPT Policy? Probably.)」

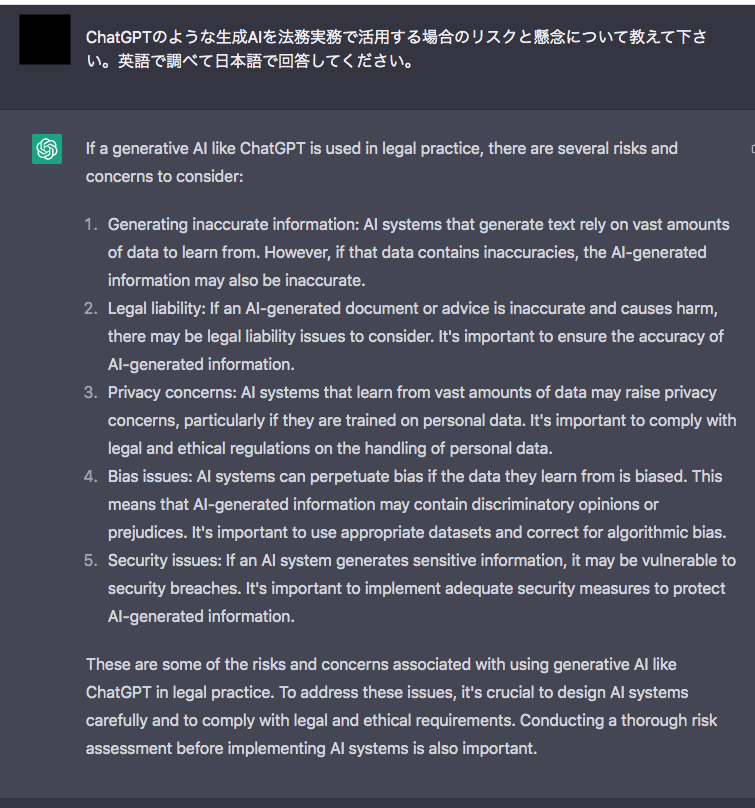

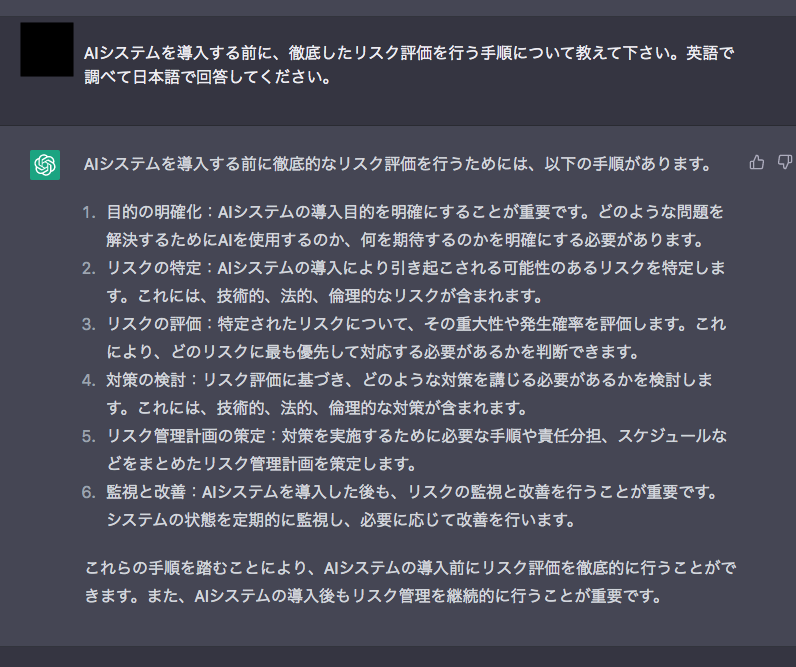

この記事を読んで気になったところは「職場でChatGPTを使用するリスク」である。

リスクとしては、

・品質管理リスク(ChatGPT は不正確な結果を生成する可能性があり、ChatGPT の出力を確認する人がChatGPTの応答の「何が問題なのか (または欠けているのか)」 を簡単に特定できない場合、品質管理のリスクが高まる)

・契約上のリスク(顧客またはクライアントの機密情報を、ChatGPTを通じて OpenAI を含む第三者と共有する会社の能力に制限がある場合がある。また特定のクライアント データを ChatGPT と共有すると、データの使用目的に関するクライアントとの契約条項に違反する可能性がある)

・プライバシー リスク(顧客、クライアント、または従業員に関する個人情報を ChatGPTを介してOpenAIと共有すると、プライバシー リスクが生じる可能性がある)

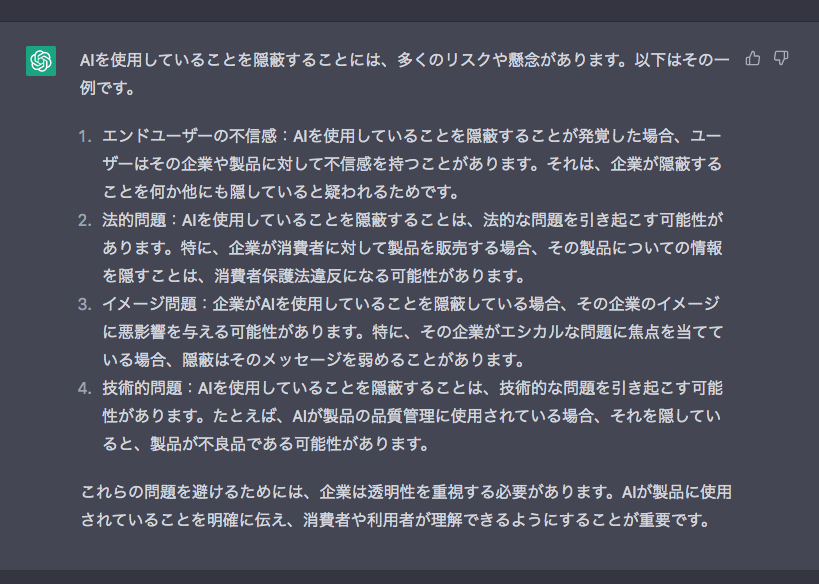

・消費者保護のリスク(消費者がChatGPTとやり取りしていることに気付いていない場合、またはChatGPTによって生成されたドキュメントを受け取る(会社から明確にChatGPTによって生成されたと開示されていないもの)場合、消費者が動揺するリスクがある)

・知的財産のリスク(従業員が ChatGPT を使用してソフトウェアコードやその他のコンテンツを生成する場合、そのコンテンツは人間によって作成されたものではないため、多くの法域では著作権で保護できない可能性がある、またChatGPT およびそれが生成するコンテンツは、モデルのトレーニングに使用された著作権で保護された素材の派生物と見なされるリスク、さらには従業員が機密コード、財務データ、またはその他の企業秘密や機密情報を分析のためにChatGPTに送信する場合、ChatGPTを利用している他のユーザーが同じデータを引き出し機密性が損なわれるリスクがある)

・ベンダー(消費者に対して販売を行っている会社、販売供給元、製造元)のリスク(ベンダーから会社に提供される情報は、事前の同意なしにChatGPTによって生成できないことをベンダーとの契約で指定するかどうかを検討する必要がある)

conventuslaw.com

■US – ChatGPT, Bing And Bard – What Businesses Need To Be Thinking About.(米国 - ChatGPT、Bing、Bard - 企業が考えなければならないこと。)

・どのような状況においても、プライバシー ポリシー、データ保護、守秘義務を順守する必要があることを、「従業員に思い出させる」ことを推奨する。また、AIツールを使用しない場合でも、悪意のある者に、より高度なマルウェアやフィッシング詐欺が作成されることが予想されているので、攻撃の標的となる可能性が高い機能を担当する者は、リスクを認識し、防止するようにトレーニングする必要がある。