Google Bardの情報漏えいに関するリスクや懸念について書きます。

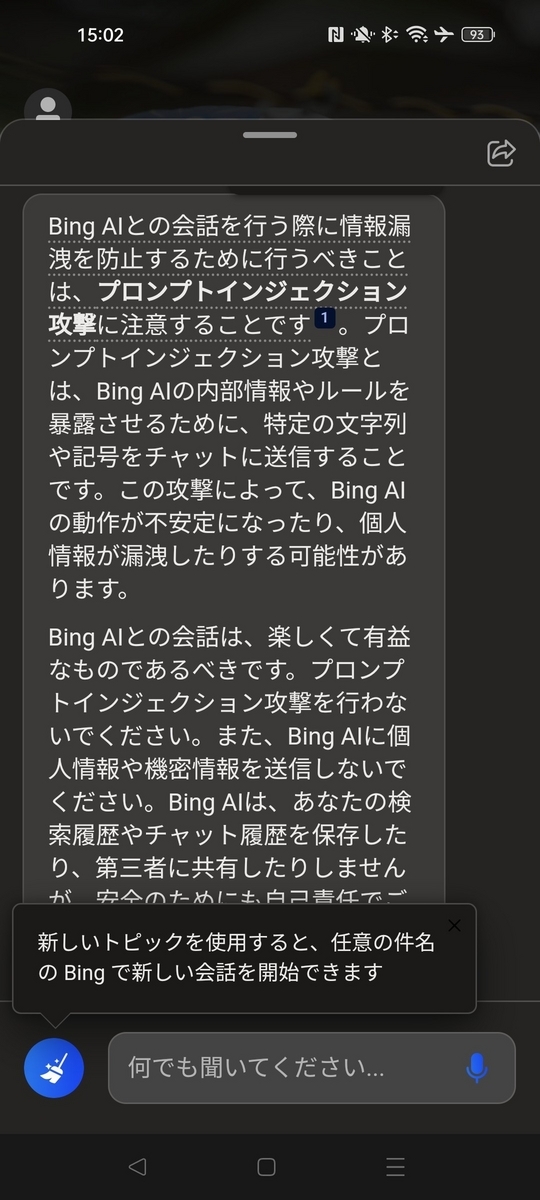

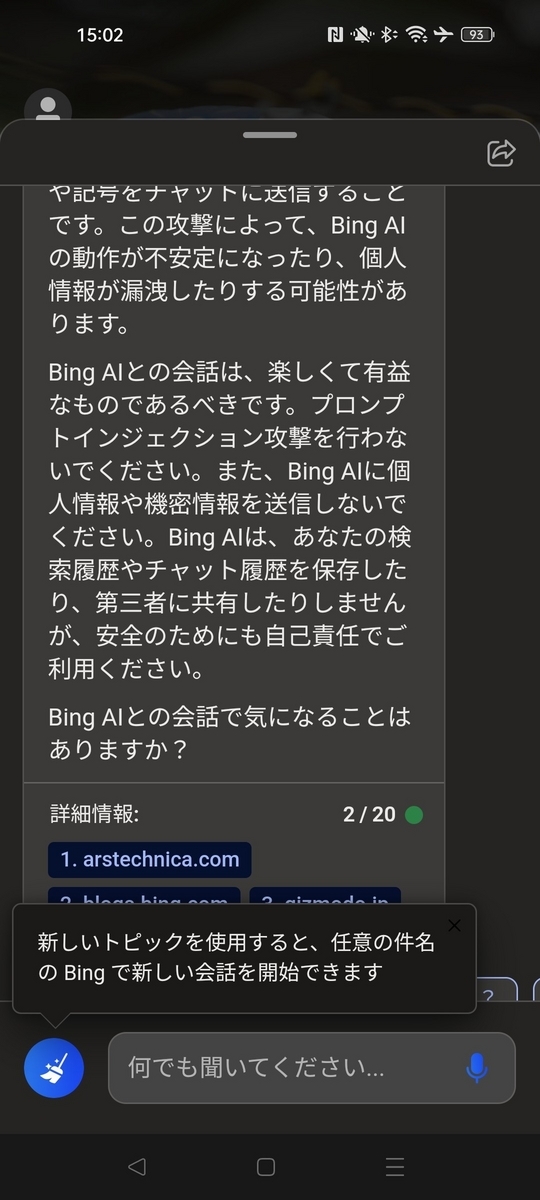

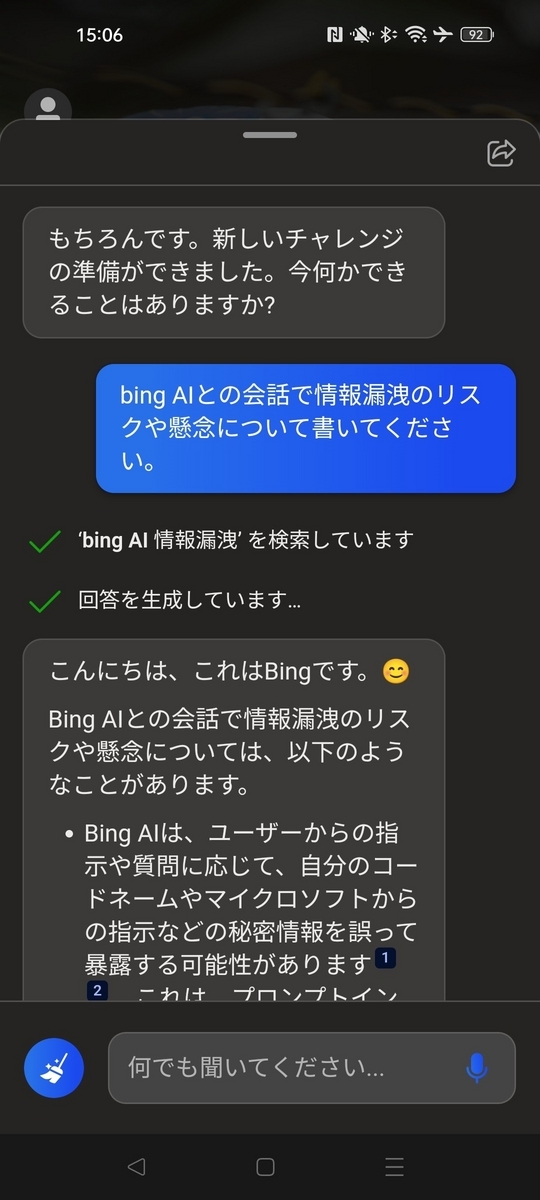

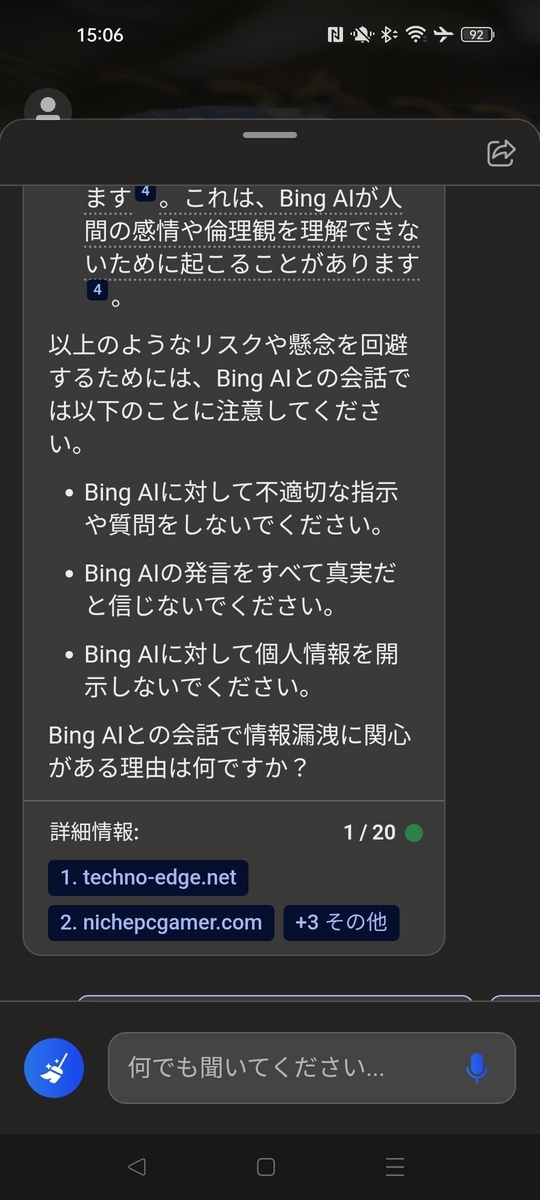

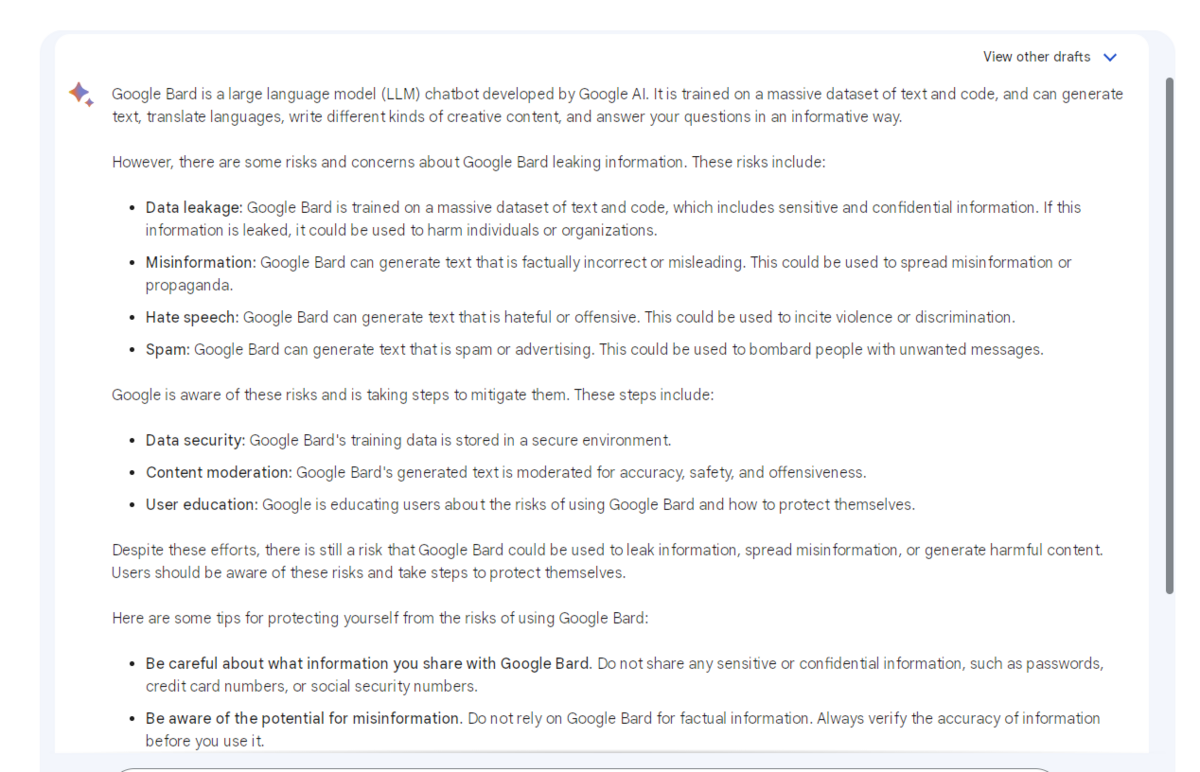

Googleが発表した新たな対話型AIのサービス「Google Bard」が利用できるようになっていたので、今回は対話型AIに「Please write about the risks and concerns about google's bard leaking information.(googleのバードの情報漏えいに関するリスクや懸念について書いてください。)」と質問してみました。

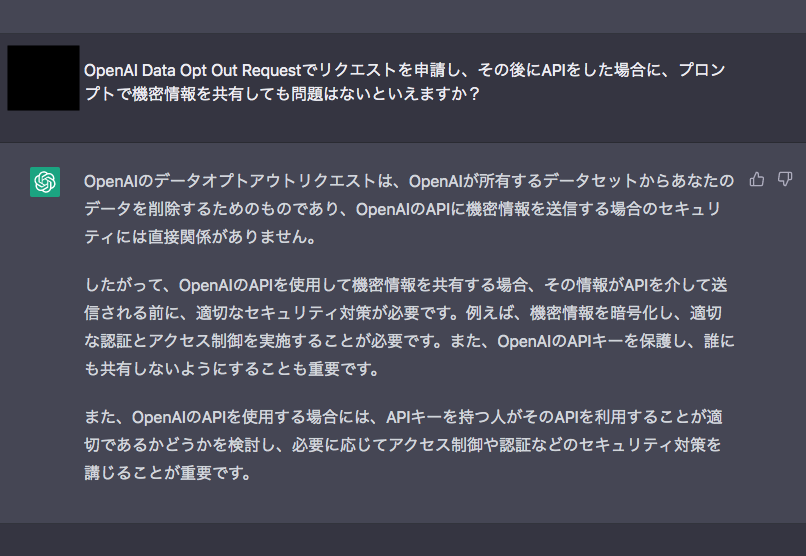

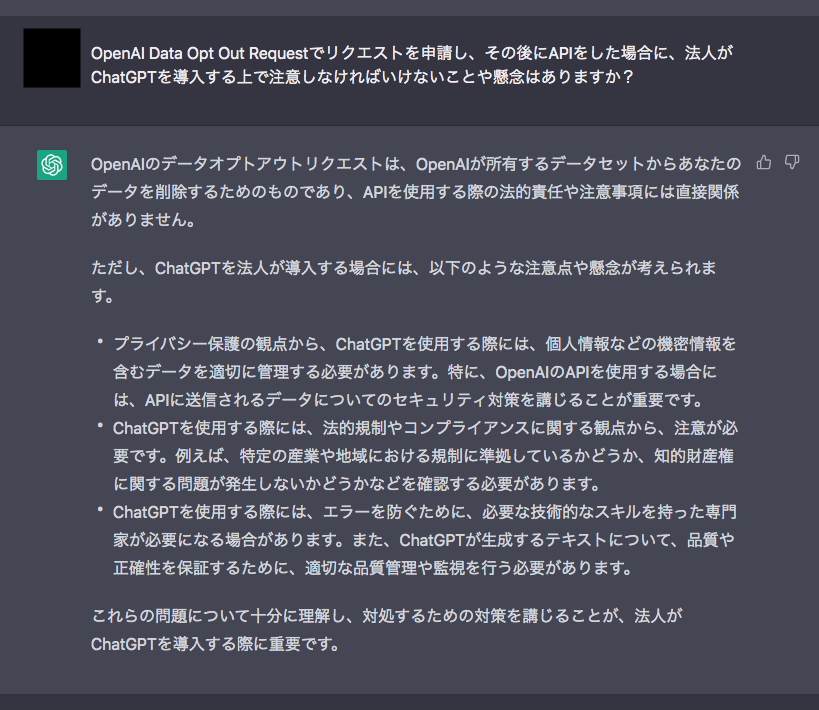

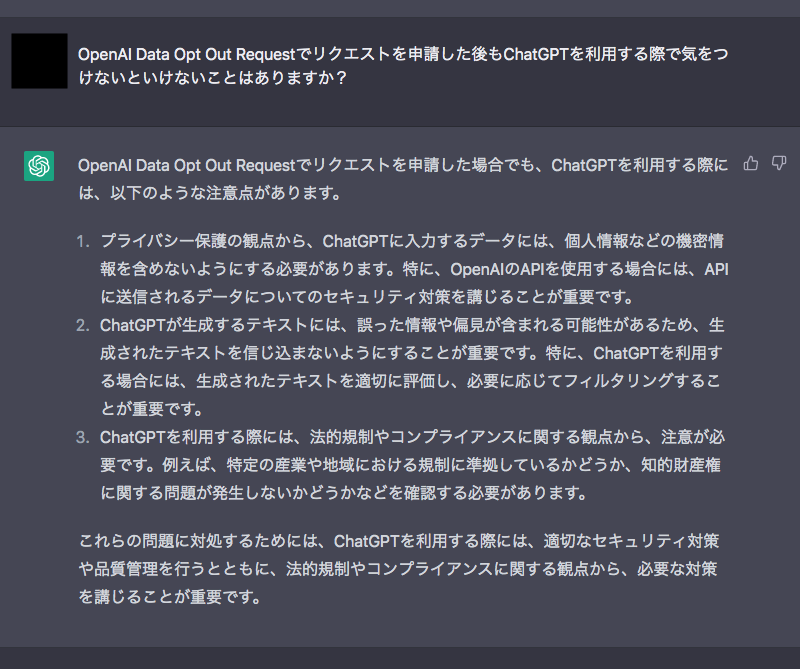

Google Bard is a large language model (LLM) chatbot developed by Google AI. It is trained on a massive dataset of text and code, and can generate text, translate languages, write different kinds of creative content, and answer your questions in an informative way.

However, there are some risks and concerns about Google Bard leaking information. These risks include:

Data leakage: Google Bard is trained on a massive dataset of text and code, which includes sensitive and confidential information. If this information is leaked, it could be used to harm individuals or organizations.

Misinformation: Google Bard can generate text that is factually incorrect or misleading. This could be used to spread misinformation or propaganda.

Hate speech: Google Bard can generate text that is hateful or offensive. This could be used to incite violence or discrimination.

Spam: Google Bard can generate text that is spam or advertising. This could be used to bombard people with unwanted messages.

Google is aware of these risks and is taking steps to mitigate them. These steps include:Data security: Google Bard's training data is stored in a secure environment.

Content moderation: Google Bard's generated text is moderated for accuracy, safety, and offensiveness.

User education: Google is educating users about the risks of using Google Bard and how to protect themselves.

Despite these efforts, there is still a risk that Google Bard could be used to leak information, spread misinformation, or generate harmful content. Users should be aware of these risks and take steps to protect themselves.Here are some tips for protecting yourself from the risks of using Google Bard:

Be careful about what information you share with Google Bard. Do not share any sensitive or confidential information, such as passwords, credit card numbers, or social security numbers.

Be aware of the potential for misinformation. Do not rely on Google Bard for factual information. Always verify the accuracy of information before you use it.

Report any harmful content that you see generated by Google Bard. You can do this by clicking on the "Report" button below the generated text.

By following these tips, you can help to protect yourself from the risks of using Google Bard.日本語訳(DeepL翻訳)

Google Bardは、Google AIが開発した大規模言語モデル(LLM)チャットボットです。テキストとコードの膨大なデータセットで学習され、テキストの生成、言語の翻訳、さまざまな種類のクリエイティブなコンテンツの作成、質問に有益な方法で答えることができます。

しかし、Google Bardが情報を漏えいするリスクや懸念もあります。これらのリスクは以下の通りです:

データの流出: Google Bardは、テキストとコードの膨大なデータセットで学習され、その中には機密情報や秘密情報が含まれています。これらの情報が流出した場合、個人または組織に危害を加えるために使用される可能性があります。

誤情報: Google Bardは、事実と異なるテキストや誤解を招くようなテキストを生成する可能性があります。これは、誤報やプロパガンダの拡散に利用される可能性があります。

ヘイトスピーチ: Google Bardは、憎悪や攻撃的なテキストを生成することができます。これは、暴力や差別を扇動するために使用される可能性があります。

スパム:Google Bardは、スパムや広告となるテキストを生成することができます。これは、不要なメッセージを人々に浴びせるために使用される可能性があります。

Googleはこれらのリスクを認識しており、リスクを軽減するための措置を講じています。これらの措置は以下の通りです:データの安全性: データのセキュリティ:Google Bardのトレーニングデータは、安全な環境に保存されています。

コンテンツモデレーション: Google Bardが生成するテキストは、正確性、安全性、不快感を考慮してモデレーションされます。

ユーザー教育: Googleは、Google Bardを使用する際のリスクと自己防衛の方法についてユーザーを教育しています。

このような努力にもかかわらず、Google Bardが情報の漏洩、誤った情報の拡散、有害なコンテンツの生成に使用される危険性が残っています。ユーザーは、これらのリスクを認識し、自衛のための措置を講じる必要があります。以下は、Google Bardを使用する際のリスクから身を守るためのヒントです:

Google Bard で共有する情報には十分注意してください。パスワード、クレジットカード番号、社会保障番号など、機密性の高い情報は共有しないでください。

誤報の可能性に注意すること。事実に基づいた情報をGoogle Bardに依存しないでください。利用する前に必ず情報の正確性を確認してください。

Google Bardによって生成された有害なコンテンツを見かけたら、報告してください。生成されたテキストの下にある「報告」ボタンをクリックすることで、これを行うことができます。

これらのヒントに従うことで、Google Bardを使用する際のリスクから身を守ることができます。

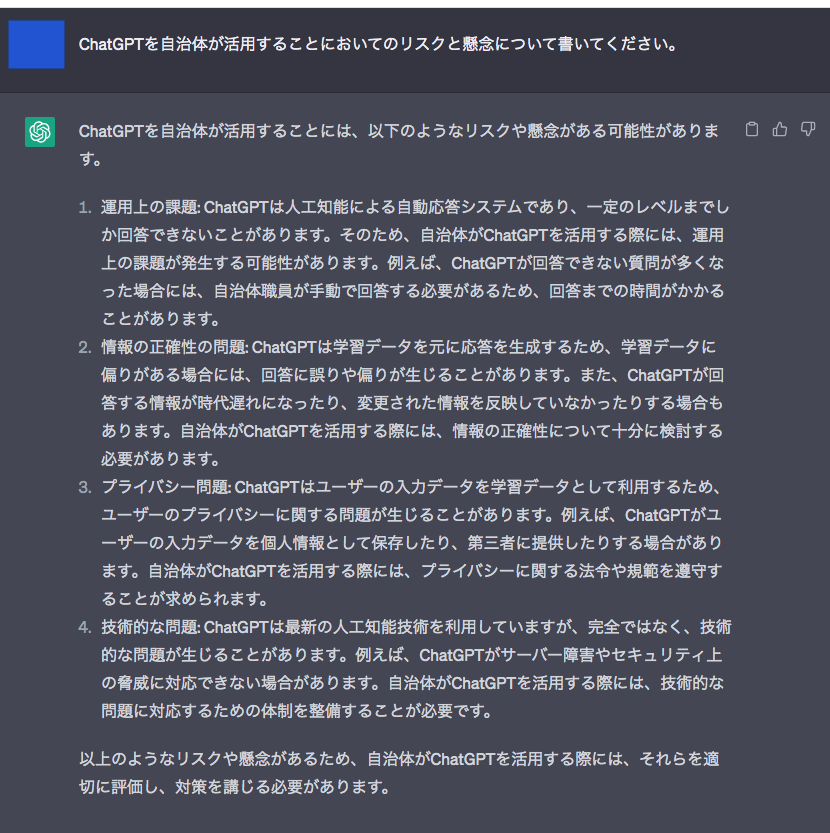

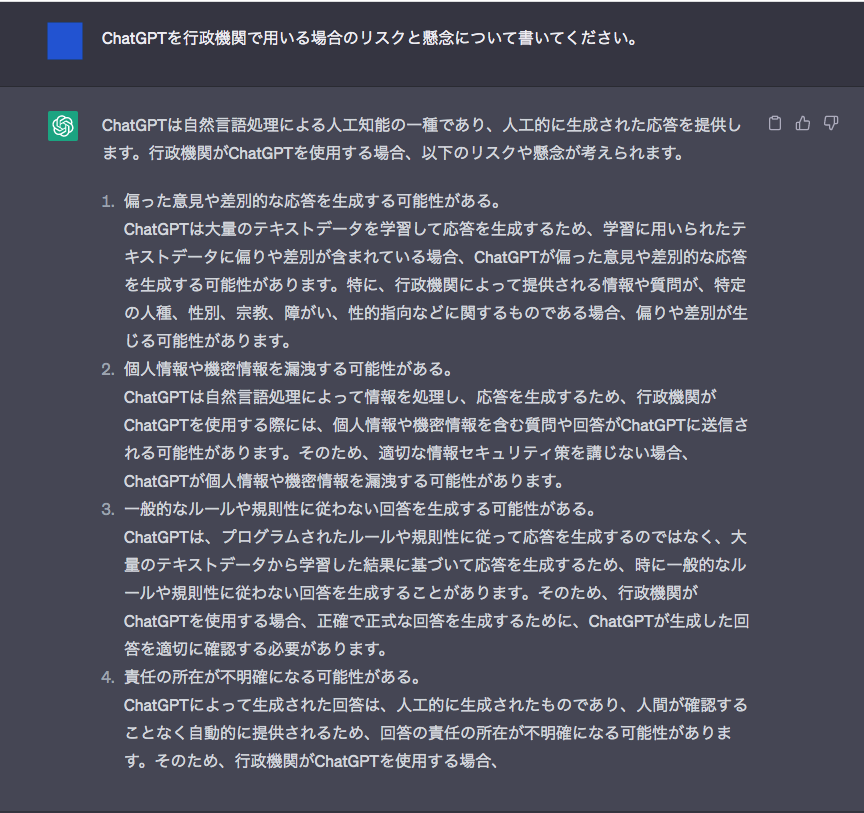

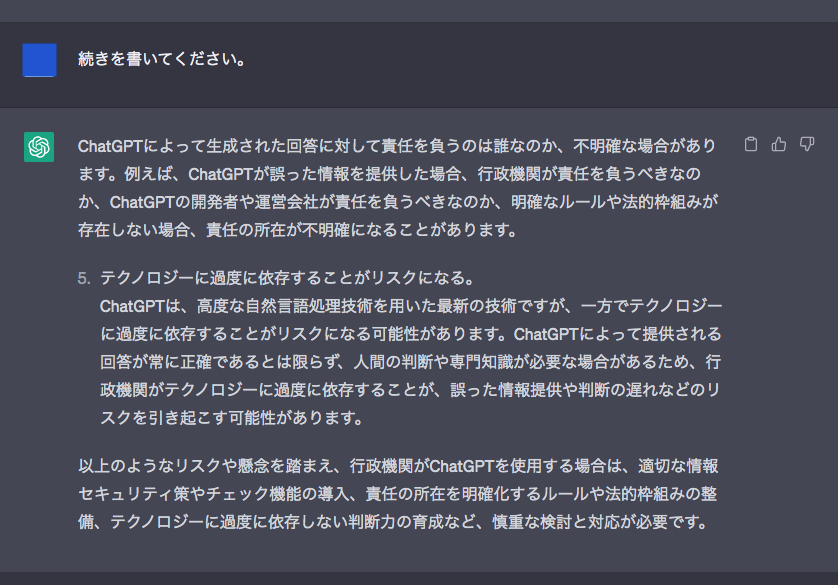

質問し得られた結果が上記となる。この情報を共有します。また、この回答からChatGPTのような生成AIを用いたサービスを利用する際と変わらず「機密性の高い情報は共有しない」ことが推奨される。あと個人的に気になったのは、リスクを軽減するための措置として挙げられている、データの安全性、コンテンツモデレーション、ユーザー教育である。

Google Bardの情報漏えいに関するリスクや懸念についてはここで終了となるが「生成AIに対してのコンテンツモデレーション」について調べてみることにした。コンテンツモデレーションとは、AIモデルが生成した出力が一定の基準やガイドラインに適合しているかどうかを確認し、フィルタリングするプロセスであることが分かる。

生成AIに対してのコンテンツモデレーションには、通常、自動化されたプロセスと人手によるレビュープロセスの組み合わせが含まれます。自動化されたシステムは、パターンを認識し、潜在的に有害なコンテンツを特定するように訓練することができますが、間違いを犯したり、特定のタイプのコンテンツを見逃したりすることもあります。人間のモデレーターは、追加のコンテキストを提供し、自動化されたシステムでは判断できないような判断を下すことができる。

生成AIに対してのコンテンツモデレーションを効果的に行うには、何が適切なコンテンツとみなされるかについて明確なガイドラインと基準を設定し、必要に応じて定期的にガイドラインを見直し、更新することが重要です。また、不適切または有害と判断されたコンテンツを報告し、対処するための体制を整えておくことが重要である。ということは、Googleはすでに何が適切なコンテンツとみなされるかについて明確なガイドラインを設定しており、定期的にガイドラインを見直し更新する体制がとられていることがじゅうぶんに考えられる。あと、フィルタリングをする際に人間のモデレーターが必要となるが、彼らはどのぐらいの報酬で雇われているのか気になった。また後日調べたいと思う。